Sora, la red social que solo deja subir vídeos creados con IA: así funciona y estos son sus riesgos

- Inteligencia artificial: la nueva máquina para sexualizar a las mujeres

- Envíanos consultas al 659 800 555 o a verificartve@rtve.es

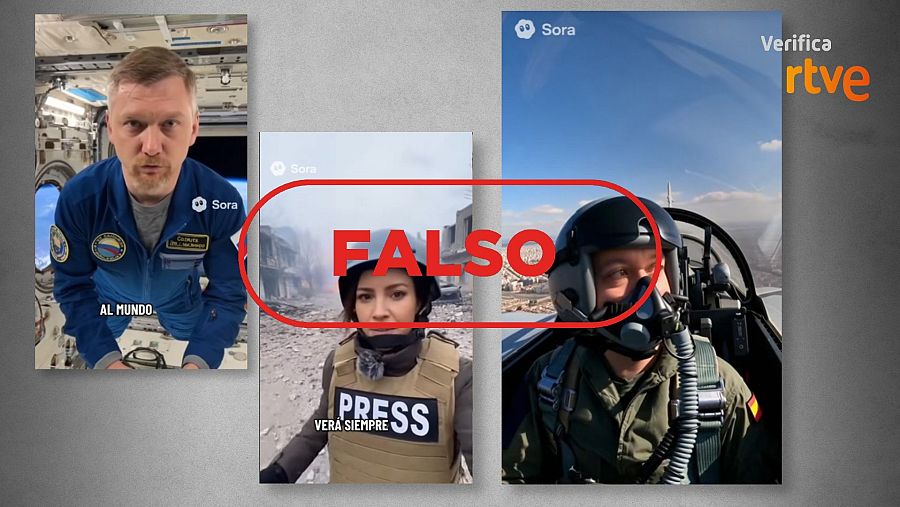

En las últimas semanas, las redes sociales se han inundado de vídeos creados con inteligencia artificial con una marca distintiva de agua: "Sora". Se trata de contenidos generados por el modelo de inteligencia artificial Sora 2. Al igual que otras herramientas, es capaz de crear imágenes ficticias que parecen reales: desde periodistas de guerra y astronautas hablando a cámara hasta la retransmisión de un piloto desde un avión durante el desfile del día de la Hispanidad. Estos contenidos proceden originalmente de una nueva red social, Sora, donde solo se pueden publicar vídeos generados con este modelo de IA. La propia aplicación invita a los usuarios a realizar deepfakes de sí mismos. En VerificaRTVE te explicamos con expertos cómo funciona, cuáles son los riesgos de ceder tu cara a la inteligencia artificial y los controles de seguridad de Sora.

"¡Hola! Esto que ves no es real. Está generado por un modelo de generación de vídeo por ordenador", dice un hombre a cámara mientras anda por la calle. En esta grabación en TikTok también aparece una periodista en mitad de una guerra, un astronauta desde el interior de una nave en el espacio y una persona llorando. Todas estas imágenes llevan una marca de agua de una nube con la palabra "Sora". Otro vídeo difundido en la misma red social, que acumula 405.300 visualizaciones, muestra a un piloto de un caza dentro de la cabina sobrevolando edificios emblemáticos de Madrid. El protagonista asegura: "Tengo Las Ventas a la vista (...) para pasar sobre Gran Vía, Madrid". En esta cuenta hay varias grabaciones del desfile del día de la Hispanidad, así como manifestaciones y accidentes. En todos aparece la marca de agua de Sora y todos ellos han sido generados con IA.

Vídeos de TikTok de personas ficticias creadas con la inteligencia artificial Sora 2 VerificaRTVE

Cada vez es más complicado detectar fallos en los vídeos creado con IA

Los vídeos de Sora han saltado a otras redes sociales, algunos de estos sin su característica marca de agua, confundiendo a los usuarios. A la hora de buscar pistas para determinar si un vídeo es falso, el analista informático forense del Observatorio Español de Delitos Informáticos (OEDI) Salvador Samper sostiene que "sigue habiendo una constante que son los ojos". Sin embargo, el experto aclara que cada vez es más complicado determinar estos fallos: "Ya cuesta tanto que se necesitan herramientas para poder contrarrestar lo que hacen otras tecnologías". Samper expone que existe una serie de herramientas para detectar vídeos generados con inteligencia artificial y que "funcionan con una fiabilidad por encima de un 95%, pero son de acceso restringido". Son algunas como UNITE, FakeCatcher (Intel), Microsoft Video AI Authenticator o Sentinel. Sin embargo, su acceso está restringido por zonas y algunas están en fase de desarrollo. Por ello, defiende que hay que "presionar para que esos medios lleguen al público y democratizar también las herramientas que contrarrestan la información". "En España existen líneas de trabajo bastante avanzadas en estas cuestiones", concluye Samper.

Los vídeos de Sora incluyen una marca de agua, pero no es suficiente para detectar si han sido generados con IA. Iván López Olmos, realizador de RTVE y experto en IA explica que "la marca de agua está bien si se aplica en toda la pantalla, de otra manera es complicado". Para el experto, "poner una marca de agua en una esquina puede disimularse, durante la edición de vídeo, con algo tan simple como ampliar el tamaño de la imagen". En esta misma línea se pronuncia Samper: "Otras inteligencias artificiales o herramientas online pueden eliminar las marcas de agua o incluso los metadatos". López Olmos concluye: "En cada casa, todo aquello que se haga con IA se debería decir".

Una red social que te invita a hacer "cameos" creando deepfakes de ti mismo

Sora fue lanzada por OpenAI, la empresa estadounidense de investigación y despliegue de inteligencia artificial en febrero de 2024. El 30 de septiembre, anunció el lanzamiento de Sora 2 como su "modelo insignia de generación de vídeo y audio". De momento, Sora solo está disponible en iPhone en Estados Unidos y en Canadá. Tal y como explica la compañía, "en la aplicación puedes crear, remezclar las creaciones de otras personas, descubrir nuevos vídeos en un catálogo de contenido recomendado personalizable". El especialista en IA y ChatGPT Amel Fernández explica a VerificaRTVE que se trata de "una red social donde todo el contenido es de IA, no se puede subir ninguna foto o vídeo, solo se genera contenido a través de inteligencia artificial".

Una de las opciones destacables de esta red social son los "cameos". Según nos explica el especialista en IA, para esta opción "te tienes que grabar un vídeo a ti mismo", la aplicación te da seis números que tienes que leer y te pide girar la cabeza en varias direcciones: "Te hacen una lectura biométrica de tu cara". Desde ese momento, "ya tienes tu avatar dentro de Sora disponible". Amel Fernández destaca que puedes "etiquetar amigos" (hasta tres personas) y "si ya han hecho su cameo dentro de la aplicación de Sora, van a aparecer" en la grabación. Esto también se puede hacer con "personajes famosos que tengan sus cameos". El experto considera que esto "democratiza la inteligencia artificial, porque los prompts (indicaciones a la IA) son muy sencillos, de hecho, los avanzados funcionan peor". Por ejemplo, puedes indicarle: "Estoy con @pepe y @juan en una catarata saltando al amanecer y te genera el vídeo completo con audio y con las tres personas".

Los riesgos de ceder tu cara a la IA

En VerificaRTVE hemos contactado con el analista informático forense del Observatorio Español de Delitos Informáticos (OEDI) Salvador Samper, quien explica que "un rostro, una oreja… Todo eso es un cálculo matemático, es un número. Cada uno tenemos un DNI en nuestro rostro y tenemos que ser absolutamente muy cuidadosos con esos datos". Prestar nuestra cara a aplicaciones de inteligencia artificial puede implicar varios riesgos:

- Perfil biométrico gratuito. Se trata de los datos físicos y de comportamiento que verifican nuestra identidad. "Los millones de perfiles biométricos que se registran, encima de manera gratuita", suponen "valor comercial" para las empresas. Por lo que supone un interés de venta a terceros.

- Almacenamiento y suplantación de identidad. Samper cuestiona "si existe una claridad de almacenamiento o no, cuánto tiempo se van a conservar datos que se pueden considerar sensibles". Según este experto, "ceder nuestra identificación única, supone que podamos ser expuestos" y que "de manera indebida" utilicen estas imágenes nuestras subidas en redes sociales "para generar un deepfake, que eso es lo más lesivo, o bien para hacer algún tipo de pornovenganza o cuestiones que incluso te puedan comprometer", como vídeos con nuestra cara con frases que no hemos pronunciado.

- Seguridad comprometida. Samper aclara que, aunque existan "medidas de seguridad biométricas", estas se pueden ver comprometidas "a nivel bancario o a nivel de dispositivos tecnológicos". Algunas empresas como Google, Apple y Samsung "tienen un chip de cifrado muy seguro", pero existen otras de las que "puede ser más fácil vulnerar sus sistemas".

- Cambios empresariales y empresas fuera de la Unión Europea. El experto alerta de que puede haber un cambio en las políticas empresariales como, por ejemplo, que una junta directiva "permita el uso no autorizado de estas imágenes, cuando originalmente no se permitía". También hay que tener en cuenta que, siendo "ciudadanos europeos", los usuarios estarán protegidos por la normativa europea, pero que "si se da un mal uso a una imagen, en el momento que compartimos algo deja de ser nuestro y otro país puede ser que no tenga la misma legislación que tenemos en Europa".

Las medidas de seguridad de Sora

Aunque crear deepfakes de ti mismo es una práctica peligrosa, el entorno de Sora y su modelo Sora 2 se presentan como un espacio seguro para los usuarios. El realizador de RTVE y experto en IA Iván López Olmos asegura que "Sora es una herramienta que tiene bastantes medidas de seguridad, al menos en la Unión Europea" y que, "de momento, con la normativa europea tiene bastantes restricciones". Así lo expresa también Salvador Samper: "OpenAI es una compañía trazable, se puede comunicar con cualquier ente gubernamental o con la Agencia Española de Protección de Datos". "Lo peor son las empresas de dudosa procedencia e incluso con posibles países en conflicto", detalla el analista del ODI.

Los usuarios controlan quién utiliza sus imágenes. La propia compañía OpenAI destaca que, "con los cameos, tienes el control total de tu imagen en Sora". Samper señala que los internautas "pueden controlar quién utiliza la imagen y quitarle los permisos de utilización" pero que "el matiz es que, si alguien hace una captura de pantalla y la sustrae fuera del entorno de Sora, puede seguir explotándola". Coincide con él el especialista en IA Amel Fernández: "Tienes varias opciones para configurar ese avatar. Tú puedes decir que solo lo usas tú, puedes dejar que lo usen los compartidos, es decir, las personas que os seguís mutuamente, o puedes permitir también que lo usen todos".

Sora tiene filtros y no permite contenidos sexualizados. Según cuenta Samper, "todo lo que tiene que ver con violencia, extremismo, discursos de odio, contenido sexual… El filtro es automático". Además, existe una "moderación importante" sobre la sexualización de la inteligencia artificial y asegura que "no te venden contenido [sexual] de niñas o de niños, sobre todo de niñas, porque el mayor consumo de inteligencia artificial es de pornografía de mujeres". Además, compara a Sora con otras herramientas que "no tienen tan desarrolladas las restricciones de interacción entre menores y adultos" para evitar el contacto de niños con groomers. En esta misma línea se pronuncia Amel Fernández: "Afortunadamente, el modelo Sora 2 no permite la generación de ningún tipo de contenido sexualizado o erótico". Además, "tiene restricciones en cuanto a mostrar el cuerpo de las personas que salen en los cameos, en ningún caso salen desnudos ni sale nada erótico, sensual".