Impacto Emocional de Música generada por Inteligencia artificial en Medios Audiovisuales

¿Puede la música generada por IA evocar las mismas respuestas emocionales que la música compuesta por humanos en contenido audiovisual? El desarrollo de la inteligencia artificial generativa es un proceso que se ha estado desarrollando a lo largo de las últimas décadas; sin embargo, su rápido progreso en los últimos años ha generado numerosos debates sobre su efecto en artistas visuales y sonoros. Una reciente investigación publicada en la revista PLOS ONE: “Impacto emocional de la música generada por IA frente a la compuesta por humanos en los medios audiovisuales: un estudio biométrico y de autoinforme” busca respuestas en la interpretación de emociones humanas a través de la IA.

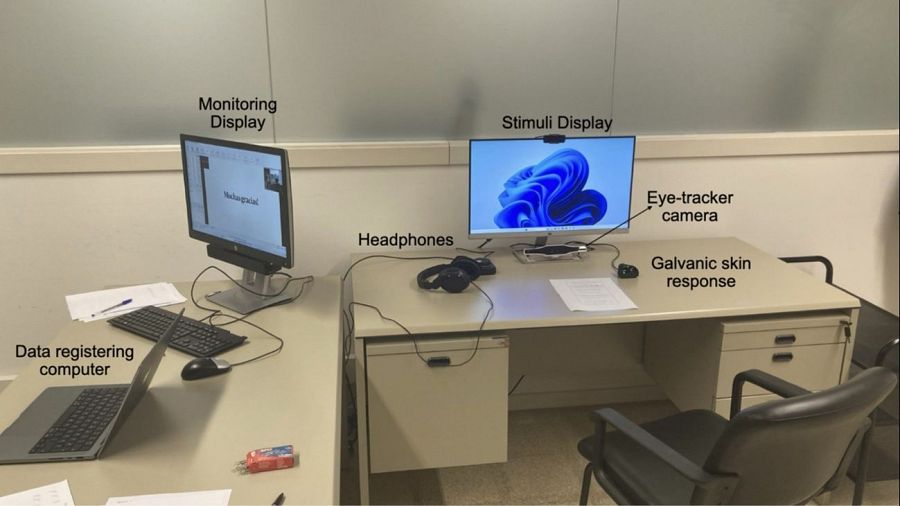

Esta investigación examinó si la creación musical impulsada por IA puede evocar el mismo impacto emocional que la música creada por humanos en contextos audiovisuales. 88 participantes vieron videos acompañados de diferentes pistas de audio en tres condiciones: música creada por humanos, música generada por IA utilizando indicaciones de palabras clave sofisticadas y detalladas, y música generada por IA utilizando indicaciones más simples y menos detalladas basadas en valores emocionales discretos y dimensionales. Durante este proceso se registraron datos biométricos (dilatación pupilar, tasa de parpadeo y respuesta galvánica de la piel) y respuestas afectivas personales.

Los resultados muestran que ambas bandas sonoras de IA condujeron a una dilatación pupilar más amplia en comparación con la música creada por humanos, pero no difirieron significativamente entre sí. La música generada por IA con indicaciones sofisticadas resultó en una mayor frecuencia de parpadeo y un nivel de impedancia de la piel como marcadores de atención y carga cognitiva, mientras que la valencia emocional se mantuvo constante en todas las condiciones. Los participantes encontraron la música generada por IA más excitante que la generada por humanos, mientras que la música hecha por humanos se percibió como más familiar que la generada por ambas condiciones de IA.

La investigación fue realizada por Nikolaj Fišer, afiliado al Programa de Doctorado en Sociología de la Cultura de la Universidad de Ljubljana, Eslovenia, y al Programa de Doctorado en Comunicación Audiovisual y Publicidad de la Universitat Autònoma de Barcelona (UAB), el doctor Miguel Ángel Martín-Pascual, responsable de Investigación y Desarrollo en el RTVE Instituto en Sant Cugat del Vallès, Barcelona, España y la doctora Celia Andreu-Sánchez, responsable del grupo de Investigación Neuro-Com, perteneciente al Instituto de Neurociencias y al Departamento de Comunicación Audiovisual y Publicidad de la UAB.

Miguel Ángel Martín-Pascual, del RTVE Instituto, considera que muchas escalas emocionales de estudios psicológicos y visuales “podrían verse mejoradas de una manera objetiva con la IA, no solo con marcadores de atención fisiológicos, sino cambiando muchas escalas de estudios que, o bien son obsoletas, o provocan un sesgo cultural en las valoraciones”.

Referencia al artículo:

https://journals.plos.org/plosone/article?id=10.1371/journal.pone.0326498

Fišer N, Martín-Pascual MÁ, Andreu-Sánchez C (2025) Emotional impact of AI-generated vs. human-composed music in audiovisual media: A biometric and self-report study. PLoS One 20(6): e0326498. https://doi.org/10.1371/journal.pone.0326498

Figura 1. Configuración del laboratorio en esta investigación. La disposición incluye un ordenador de registro de datos, una pantalla de monitorización, auriculares, una pantalla de estímulos, una cámara de seguimiento ocular y un dispositivo para medir la respuesta cutánea y la frecuencia cardíaca. RTVE Instituto