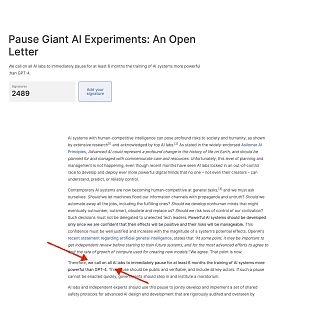

“Los sistemas de IA con inteligencia humana competitiva pueden plantear profundos riesgos para la sociedad y la humanidad… Los sistemas de IA potentes deberían desarrollarse sólo cuando estemos seguros de que sus efectos serán positivos y sus riesgos controlables”. Por todo ello, más de mil científicos y desarrolladores de primer nivel, incluidos los nombres de Elon Musk o Steve Wozniak y algunos más cercanos y conocidos por este programa como Ramón López de Mántaras (Instituto de Inteligencia Artificial), han firmado una carta abierta, que por aquello que pide, la paralización de los experimentos “gigantes” en IA (Con especial ejemplo y atención a Chat GPT-4) y por quienes la firman, hay quien la ha comparado con la carta abierta un arrepentido Einstein junto Bertrand Russell y los 10 científicos más importantes del momento firmaron en contra del uso militar de la energía nuclear. “Recordad vuestra humanidad y olvidad el resto”, decían…

¿Qué hay detrás de esta petición urgente a parar el desarrollo de la IA más potente durante 6 meses? ¿Hay un peligro real? Analizamos la cuestión desde un foro privilegiado, el del Metatarso, aprovechando la celebración del Meta World Congress en Madrid, y añadiendo un asunto de interés ¿se puede enseñar empatía a las inteligencias artificiales? ¿Tenemos que redefinir el concepto de “Valle Inquietante”?. Hablamos con:

Javier Furones (CEO de Voicehumans)

Santiago Sánchez-Migallón, experto en filosofía (Máquina de Von Neumann)

Óscar González (Real o Virtual)

Y con Don Víctor, no abandonamos el metatarso ni los robots para disfrutar de los cómics más cercanos al Uncanny Valley.